Obsah

- Velká data jsou nestrukturovaná nebo polostrukturovaná

- Pokud nemůžeme zpracovat velká data, nemá smysl ukládat velká data

- Jak Hadoop řeší problém velkých dat

- Obchodní případ společnosti Hadoop

Odnést:

Hadoop může pomoci vyřešit některé velké výzvy velkých dat.

Velká data jsou ... dobře ... velká velikost! Přesně to, jak velké množství dat lze klasifikovat jako velká data, není příliš jasné, takže se v této debatě nesmíme zapadnout. Pro malou společnost, která je zvyklá na zpracování dat v gigabajtech, by 10 TB dat bylo BIG. Nicméně pro společnosti jako Yahoo a petabytes je velký.Pouhá velikost velkých dat znemožňuje (nebo alespoň omezuje náklady) jejich uložení v tradičním úložišti, jako jsou databáze nebo konvenční filtry. Hovoříme o nákladech na ukládání gigabajtů dat. Používání tradičních úložných souborů může stát mnoho peněz za ukládání velkých dat.

Zde se dobře podívejte na velká data, na jejich výzvy a na to, jak je Hadoop může vyřešit.Za prvé, velké datové největší výzvy.

Velká data jsou nestrukturovaná nebo polostrukturovaná

Mnoho velkých dat není strukturováno. Například data v protokolu streamu kliknutí mohou vypadat takto:časové razítko, user_id, stránka, referrer_page

Nedostatek struktury způsobuje, že relační databáze nejsou vhodné pro ukládání velkých dat. Navíc není mnoho databází schopno zvládnout ukládání miliard řádků dat.

Pokud nemůžeme zpracovat velká data, nemá smysl ukládat velká data

Ukládání velkých dat je součástí hry. Musíme to zpracovat, abychom z toho vytěžili inteligenci. Tradiční úložné systémy jsou docela „hloupé“ v tom smyslu, že pouze ukládají kousky. Nenabízejí žádnou zpracovatelskou sílu.Tradiční model zpracování dat obsahuje data uložená v úložném clusteru, který je zkopírován do výpočetního clusteru ke zpracování. Výsledky jsou zapsány zpět do úložného clusteru.

Tento model však nefunguje pro velká data, protože kopírování tolika dat do výpočetního klastru může být časově náročné nebo nemožné. Jaká je tedy odpověď?

Jedním z řešení je zpracování velkých dat na místě, jako je zdvojnásobení úložného clusteru jako výpočetní cluster.

Jak jsme viděli výše, velká data vzdorují tradičnímu úložišti. Jak tedy zvládneme velká data?

Jak Hadoop řeší problém velkých dat

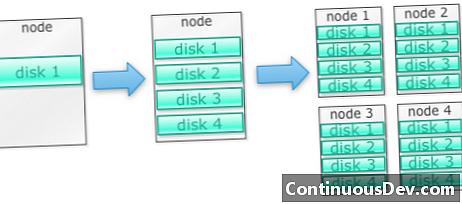

Hadoop je postaven tak, aby fungoval na klastru strojůZačněme příkladem. Řekněme, že musíme uložit spoustu fotografií. Začneme jedním diskem. Pokud překročíme jeden disk, můžeme použít několik disků naskládaných na stroji. Když maximalizujeme všechny disky na jednom počítači, musíme získat spoustu strojů, každý s partou disků.

To je přesně to, jak je postaven Hadoop. Hadoop je navržen tak, aby fungoval na klastru strojů od samého začátku.

Hadoop clustery měřítko vodorovně

Více úložného a výpočetního výkonu lze dosáhnout přidáním více uzlů do klastru Hadoop. To vylučuje nutnost nákupu stále silnějšího a dražšího hardwaru.

Hadoop umí zpracovat nestrukturovaná / polostrukturovaná data

Hadoop nevynucuje schéma uložených dat. Dokáže zpracovat libovolná a binární data. Hadoop tak může snadno strávit jakákoli nestrukturovaná data.

Klastry Hadoop poskytují úložiště a výpočetní techniku

Viděli jsme, jak mít oddělené klastry pro ukládání a zpracování není nejlepší pro velká data. Klastry Hadoop však poskytují úložiště a distribuované výpočty vše v jednom.

Obchodní případ společnosti Hadoop

Hadoop poskytuje úložiště velkých dat za rozumnou cenu

Ukládání velkých dat pomocí tradičního úložiště může být drahé. Hadoop je postaven na komoditním hardwaru, takže poskytuje poměrně velké úložiště za rozumnou cenu. Hadoop byl použit v poli v petabyte měřítku.

Jedna studie společnosti Cloudera naznačila, že podniky obvykle utratí zhruba 25 000 až 50 000 USD za terabajt ročně. U společnosti Hadoop tato cena klesne na několik tisíc dolarů za terabajt za rok. Protože hardware je levnější a levnější, tyto náklady stále klesají.

Hadoop umožňuje zachycení nových nebo více dat

Organizace někdy nezachycují typ dat, protože jejich uložení bylo příliš nákladné. Protože Hadoop poskytuje úložiště za rozumnou cenu, lze tento typ dat zachytit a uložit.

Jedním příkladem by mohly být protokoly kliknutí na webové stránky. Protože objem těchto protokolů může být velmi vysoký, nezachytilo je mnoho organizací. Nyní lze pomocí Hadoop zaznamenávat a ukládat protokoly.

S Hadoopem můžete ukládat data déle

Pro správu objemu uložených dat společnosti pravidelně odstraňují starší data. Například bylo možné uložit pouze protokoly za poslední tři měsíce, zatímco starší protokoly byly odstraněny. S Hadoopem je možné ukládat historická data déle. To umožňuje provádět nové analýzy na starších historických datech.

Například můžete zaznamenat kliknutí z webu. Před několika lety byly tyto protokoly uloženy na krátkou dobu pro výpočet statistik jako oblíbené stránky. Nyní s Hadoopem je možné tyto protokoly kliknutí ukládat delší dobu.

Hadoop poskytuje škálovatelnou analytiku

Pokud je nemůžeme analyzovat, nemá smysl ukládat všechna tato data. Hadoop poskytuje nejen distribuované úložiště, ale také distribuované zpracování, což znamená, že můžeme paralelně rozdrtit velký objem dat. Výpočtový rámec Hadoop se nazývá MapReduce. MapReduce se osvědčil na úrovni petabytů.

Hadoop poskytuje bohatou analytiku

Native MapReduce podporuje Javu jako primární programovací jazyk. Lze použít i jiné jazyky, jako jsou Ruby, Python a R.

Psaní vlastního kódu MapReduce samozřejmě není jediným způsobem, jak analyzovat data v Hadoopu. K dispozici je mapa na vyšší úrovni. Například nástroj s názvem Pig bere angličtinu jako jazyk toku dat a převádí je do MapReduce. Jiný nástroj, Hive, přijímá dotazy SQL a spouští je pomocí MapReduce.

Nástroje Business Intelligence (BI) mohou poskytnout ještě vyšší úroveň analýzy. Pro tento typ analýzy existují také nástroje.

Tento obsah je výňatek z „Hadoop Illuminated“ od Mark Kerzner a Sujee Maniyam. Byl zpřístupněn prostřednictvím Creative Commons Attribution-NonCommerce-ShareAlike 3.0 Unported License.