Obsah

- Definice - Co znamená Hadoop Distributed File System (HDFS)?

- Úvod do Microsoft Azure a Microsoft Cloud | V této příručce se dozvíte, o čem cloud computing je a jak vám může Microsoft Azure pomoci migrovat a řídit podnikání z cloudu.

- Techopedia vysvětluje systém Hadoop Distributed File System (HDFS)

Definice - Co znamená Hadoop Distributed File System (HDFS)?

Distribuovaný systém souborů Hadoop (HDFS) je distribuovaný systém souborů, který běží na standardním nebo nízkém hardwaru. HDFS, vyvinutý společností Apache Hadoop, funguje jako standardní distribuovaný souborový systém, ale poskytuje lepší propustnost a přístup k datům pomocí algoritmu MapReduce, vysokou odolnost proti chybám a nativní podporu velkých datových souborů.

Úvod do Microsoft Azure a Microsoft Cloud | V této příručce se dozvíte, o čem cloud computing je a jak vám může Microsoft Azure pomoci migrovat a řídit podnikání z cloudu.

Techopedia vysvětluje systém Hadoop Distributed File System (HDFS)

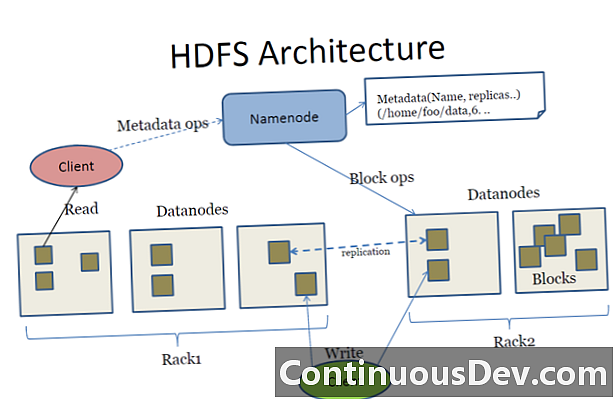

HDFS ukládá velké množství dat umístěných na více počítačích, obvykle ve stovkách a tisících současně připojených uzlů, a poskytuje spolehlivost dat replikováním každé datové instance jako tři různé kopie - dvě v jedné skupině a jedna v druhé. Tyto kopie mohou být v případě poruchy vyměněny.

Architektura HDFS sestává z klastrů, z nichž každý je přístupný prostřednictvím jediného softwarového nástroje NameNode nainstalovaného na samostatném stroji, který monitoruje a spravuje souborový systém klastrů a mechanismus přístupu uživatelů. Ostatní počítače instalují jednu instanci DataNode pro správu úložiště clusterů.

Protože je HDFS psán v Javě, má nativní podporu pro programovací rozhraní Java API (API) pro integraci a přístupnost aplikací. Je také přístupný prostřednictvím standardních webových prohlížečů.