Obsah

Q:

Proč jsou umělé opakující se neuronové sítě často obtížně trénovatelné?

A:

Obtížnost výcviku umělých opakujících se neuronových sítí souvisí s jejich složitostí.

Jedním z nejjednodušších způsobů, jak vysvětlit, proč se opakující se neuronové sítě těžko trénují, je to, že se nejedná o dopředné neuronové sítě.

V dopředných neuronových sítích se signály pohybují pouze jednou cestou. Signál se přesouvá ze vstupní vrstvy do různých skrytých vrstev a dopředu k výstupní vrstvě systému.

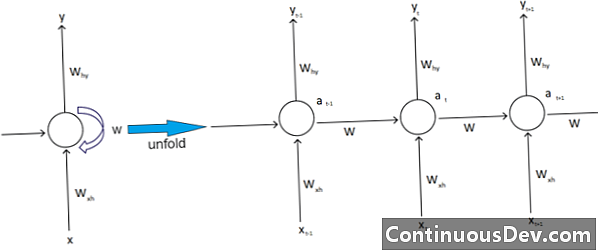

Naproti tomu opakující se neuronové sítě a další různé typy neuronových sítí mají složitější pohyby signálu. Rekurentní neuronové sítě, které jsou klasifikovány jako „zpětné vazby“, mohou mít signály pohybující se vpřed i vzad a mohou obsahovat různé „smyčky“ v síti, kde jsou čísla nebo hodnoty přiváděny zpět do sítě. Odborníci to spojují s aspektem opakujících se neuronových sítí, které jsou spojeny s jejich pamětí.

Kromě toho existuje další typ složitosti ovlivňující opakující se neurální sítě. Jedním z vynikajících příkladů je zpracování přirozeného jazyka.

Při sofistikovaném zpracování přirozeného jazyka musí neuronová síť být schopna si pamatovat věci. Musí brát také vstupy v kon. Předpokládejme, že existuje program, který chce analyzovat nebo předpovídat slovo ve větě jiných slov. Systém může například mít pevnou délku pěti slov pro vyhodnocení. To znamená, že neuronová síť musí mít vstupy pro každé z těchto slov, spolu se schopností „si pamatovat“ nebo trénovat na konci těchto slov. Z těchto a jiných podobných důvodů mají rekurentní neuronové sítě v systému obvykle tyto malé skryté smyčky a zpětné vazby.

Odborníci naříkají, že tyto komplikace ztěžují trénink sítí. Jedním z nejčastějších způsobů, jak to vysvětlit, je citovat explodující a mizející problém s gradientem. Hmotnosti sítě v zásadě povedou k explozi nebo zmizení hodnot s velkým počtem průchodů.

Průkopník neuronové sítě Geoff Hinton vysvětluje tento jev na webu tím, že říká, že zpětné lineární průchody způsobí, že se menší hmotnosti exponenciálně zmenší a větší hmotnosti explodují.

Tento problém se dále zhoršuje dlouhými sekvencemi a četnými časovými kroky, ve kterých signály rostou nebo se rozpadají. Inicializace váhy může pomoci, ale tyto výzvy jsou zabudovány do modelu opakující se neuronové sítě. Vždy je to problém spojený s jejich konkrétním designem a sestavením. V podstatě některé složitější typy neuronových sítí opravdu vzdorují naší schopnosti snadno je spravovat. Můžeme vytvořit prakticky nekonečné množství složitosti, ale často vidíme, že výzvy spojené s předvídatelností a škálovatelností rostou.